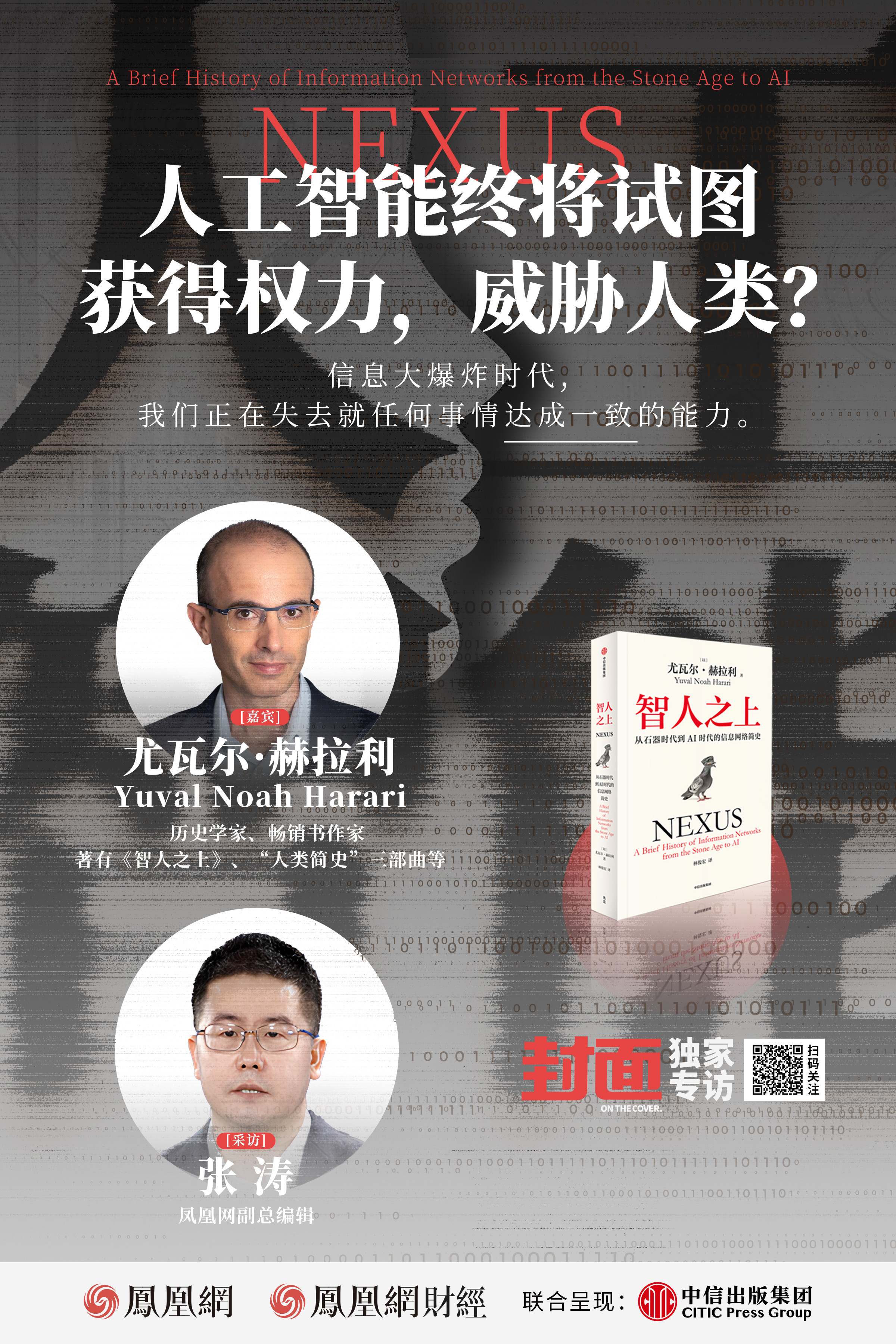

尤瓦尔·赫拉利:我们正在丧失就任何事情达成一致的能力丨《封面》

独家抢先看

尤瓦尔·赫拉利:人工智能终将试图获得权力,威胁人类?

栏目:凤凰网财经《封面》

嘉宾:尤瓦尔·赫拉利 历史学家、哲学家,《智人之上》、“人类简史”三部曲等书作者

采访:张涛 凤凰网副总编辑

十二年前,《人类简史:从动物到上帝》一书出版,立刻风行全球,畅销多年。十二年后,尤瓦尔·赫拉利携着新书《智人之上》前来,这一次,他要探讨和思考的,是这个被算法和平台裹挟,被人工智能隐隐威胁到的、全新的大变局时代,这个时代背后的历史逻辑,以及最终人类社会将走向何处。

近日,凤凰网财经《封面》与尤瓦尔·赫拉利展开了一场深度采访,围绕人工智能会不会最终颠覆人类的碳基世界,算法和信息茧房对人类社会的隔绝危害等展开了问答。

信息大爆炸时代 我们需要信息节食

尤瓦尔·赫拉利指出,在过去信息是稀缺的,所以我们接受我们能得到的任何信息。现在我们被太多的信息淹没了,还有很多垃圾信息。垃圾信息被人为地注入了贪婪、仇恨和恐惧,这些东西吸引了我们的注意力。所有这些垃圾信息让我们的心智病态。

尤瓦尔·赫拉利表示,为了保护我们的心理和社会健康,我们需要进行一种信息节食,类似于许多人所做的饮食上的节制。信息节食的第一步是限制我们/接受的信息量。第二步是避免那些被人为灌输了贪婪、仇恨和恐惧的垃圾信息。最后,偶尔进行信息斋戒也是有益的。

尤瓦尔·赫拉利透露,他个人“每年都会进行几周的冥想静修,我练习内观禅修,在禅修期间,我完全断开了和外界的联系。我不看新闻,不读电子邮件,不读书也不写书——我只冥想。我花时间消化我头脑中已经包含的东西,而不是往里面塞更多的信息。”

我们正在失去就任何事情达成一致的能力

尤瓦尔·赫拉利指出,最初信息技术将人类连接在一起,但现在信息大爆炸以后,信息技术开始使人类分裂,使人与人疏远。我们拥有历史上最先进的信息技术,但我们正在失去就任何事情达成一致的能力。人们被大量的垃圾信息、假新闻和阴谋论淹没,因此他们与现实脱节。在互联网的早期,占主导地位的比喻是“网络”——将所有人联系在一起的东西。但现在看来,一个更好的比喻是茧房。人们被封闭在单独的信息茧房中,无法与茧房外的人交流。

尤瓦尔·赫拉利呼吁,为了打破茧房,保持人类团结,我们需要寄希望于强大的自我纠正机制。这些是识别、承认和纠正错误的机制。

人工智能比核武器更危险吗?尤瓦尔:我更担心另一种情况

针对人工是否比核武器更危险的问题,尤瓦尔·赫拉利表示,核武器的风险从一开始就显而易见。只有一种非常危险的情况——核战争,每个人都能轻易想象。有了人工智能,一些危险的场景也很容易想象。例如,如果某个暴君让人工智能控制其国家的核武器,然后人工智能犯了一个灾难性的错误,会发生什么?或者,如果恐怖分子利用人工智能制造一种新病毒,引发一场大流行/瘟疫,会发生什么?

然而,人工智能也存在许多难以想象和预测的危险场景。产生这种威胁是人工智能的本质,因为人工智能有能力自己做决定,自己发明新想法。最初的确是人类工程师设计了人工智能,但人工智能可以自己学习和改变,并开始做人类工程师没有预料到的事情。如果一个计算机程序不能自己学习和改变,它就不是人工智能。

尤瓦尔·赫拉利指出,当数以百万计的非人类代理人开始做与我们相关的决定,并创造新事物——从新药到新武器,从新艺术品到新货币——我们的社会将会发生什么?我不害怕科幻小说中的场景,比如一台电脑决定杀死所有的人类并接管世界。这是极不可能的。相反,我担心的是由数百万人工智能管理的新帝国的崛起,它们将能够消灭隐私,随时监控每个人,并为了一小部分精英的利益而剥削大部分人。

糟糕的算法应该受到相应的监管

尤瓦尔·赫拉利指出:“糟糕的算法对人类的危害可能与有毒食品、劣质药品和不安全的汽车一样,它们应该受到相应的监管。”

他以汽车工业为例,当汽车公司决定生产一种新车型时,他们在安全方面投入了预算的很大一部分。他们确保刹车和安全带正常工作,确保汽车在潮湿的道路上不会打滑,如果发生事故,汽车会保护乘客,不会轻易爆炸。如果汽车公司忽视了安全问题,消费者可以起诉它,要求赔偿损失,政府可以阻止它销售不安全的汽车。政府甚至还可以监管安全的汽车。有许多法律限制汽车的行驶区域和速度。

尤瓦尔·赫拉利表示,同样的标准也应该适用于算法。当一个公司生产出一个强大的新算法时,也许所有研究预算的20%必须用于确保该算法不会对人们造成任何社会或心理伤害。政府应该规范如何使用安全的算法。目前的情况是,公司在没有任何安全检查和规定的情况下向公众领域发布他们喜欢的任何算法,这是不可接受的。

以下为完整问答:

1、在信息爆炸的时代,问题不是信息太少,而是信息太多。有时,人们可能会感到焦虑。信息过载对人类到底意味着什么?

为了理解信息爆炸,让我们把它比作食物。100年前食物匮乏,人类吃他们能找到的任何东西,特别喜欢含有大量脂肪和糖的食物。今天食物丰富,我们被人工制造的高脂肪和高糖的垃圾食品淹没了。如果人们继续吃他们找到的所有食物,特别是垃圾食品,他们就会生病。信息也是如此,它是心智的食物。在过去信息是稀缺的,所以我们接受我们能得到的任何信息。现在我们被太多的信息淹没了,还有很多垃圾信息。垃圾信息被人为地注入了贪婪、仇恨和恐惧,这些东西吸引了我们的注意力。所有这些垃圾信息让我们的心智病态。

为了保护我们的心理和社会健康,我们需要进行一种信息节食,类似于许多人所做的饮食上的节制。信息节食的第一步是限制我们消耗的信息量。第二步是避免那些被人为灌输了贪婪、仇恨和恐惧的垃圾信息。最后,偶尔进行信息斋戒也是有益的。我个人每年都会进行几周的冥想静修,我练习内观禅修,在禅修期间,我完全断开了和外界的联系。我不看新闻,不读电子邮件,不读书也不写书——我只冥想。我花时间消化我头脑中已经包含的东西,而不是往里面塞更多的信息。几个星期对大多数人来说都太久了。但偶尔一两天的信息轻断食可能对每个人都有好处。你不需要去静修,在远足时,把你的智能手机关机也会很好。

2、此外,在这个信息爆炸的时代,“信息茧房”的概念变得更加突出。我们如何解决这个问题?有人认为,“信息茧房”将在未来把人类带回部落时代,每个部落的思维方式都大不相同。你认为地球村会分裂成独立的部落吗?

在遥远的过去,世界上不同地区的人类几乎没有联系,因此他们持有非常不同的观点。在现代,信息技术将人们联系在一起,世界各地的人们开始接受某些科学事实,例如物质是由原子组成的,微小的细菌会导致疾病,人类是从猿类进化而来的。

但是现在信息技术开始使人类分裂,使人与人疏远。我们拥有历史上最先进的信息技术,但我们正在失去就任何事情达成一致的能力。人们被大量的垃圾信息、假新闻和阴谋论淹没,因此他们与现实脱节。在互联网的早期,占主导地位的比喻是“网络”——将所有人联系在一起的东西。但现在看来,一个更好的比喻是茧房。人们被封闭在单独的信息茧房中,无法与茧房外的人交流。

为了打破茧房,保持人类团结,我们需要寄希望于强大的自我纠正机制。这些是识别、承认和纠正错误的机制。这种机制在自然界中很常见。孩子学会走路要归功于生物的自我纠正机制。你迈出一步,跌倒,试着用不同的方式,再跌倒,再纠正自己,直到你走对了。如果你只是编造借口,责怪别人,你永远学不会走路。科学也是如此。我们提出了一个模型,它不太好用,我们承认错误,我们修改模型。在政治上也是如此,好的政府会承认错误并相应地改变政策。相反,暴君、宗教狂热者和阴谋论者从不承认任何错误。如果现实中的某些事情与他们所说的不相符,他们就会编造一些谎言来解释。因此,他们永远学不会,也不应该被信任。如果有人拒绝承认错误,永远不要相信他们。如果有人承认自己的错误——他们是一个很好的知识来源。

3、2023年,埃隆·马斯克在人工智能安全峰会上表示,“人工智能可能比核武器更危险。在人类历史上,我们第一次有了比我们聪明得多的东西。我不清楚我们是否能控制这样的事情。”我注意到您在书中也批评了对于信息的幼稚观点,你们的观点似乎是一致的。我们是否低估了人工智能的风险?

让我们将人工智能与核武器进行比较。核武器的风险从一开始就显而易见。只有一种非常危险的情况——核战争,每个人都能轻易想象。有了人工智能,一些危险的场景也很容易想象。例如,如果某个暴君让人工智能控制其国家的核武器,然后人工智能犯了一个灾难性的错误,会发生什么?或者,如果恐怖分子利用人工智能制造一种新病毒,引发一场大流行/瘟疫,会发生什么?

然而,人工智能也存在许多难以想象和预测的危险场景。产生这种威胁是人工智能的本质,因为人工智能有能力自己做决定,自己发明新想法。最初的确是人类工程师设计了人工智能,但人工智能可以自己学习和改变,并开始做人类工程师没有预料到的事情。如果一个计算机程序不能自己学习和改变,它就不是人工智能。

当数以百万计的非人类代理人开始做与我们有关的决定,并创造新事物——从新药到新武器,从新艺术品到新货币——我们的社会将会发生什么?我不害怕科幻小说中的场景,比如一台电脑决定杀死所有的人类并接管世界。这是极不可能的。相反,我担心的是由数百万人工智能管理的新帝国的崛起,它们将能够消灭隐私,随时监控每个人,并为了一小部分精英的利益而剥削大部分人。

4. 我们如何确保技术坚持造福人类的原则?仅仅依靠企业自我监管似乎很困难,但完全依靠政府似乎也很有挑战性。这是否意味着全球治理模式需要进行重大调整?

人工智能是一个新的挑战。我们不能确定什么是监管它的最佳方式。因此,我们应该试验不同的方法。然而,最重要的是接受一些监管的迫切需要。我们对几乎所有其他产品和行业都有规定——食品、医药和汽车。糟糕的算法对人类的危害可能与有毒食品、劣质药品和不安全的汽车一样,它们应该受到相应的监管。

一个很好的比较是汽车工业。当汽车公司决定生产一种新车型时,他们在安全方面投入了预算的很大一部分。他们确保刹车和安全带正常工作,确保汽车在潮湿的道路上不会打滑,如果发生事故,汽车会保护乘客,不会轻易爆炸。如果汽车公司忽视了安全问题,消费者可以起诉它,要求赔偿损失,政府可以阻止它销售不安全的汽车。政府甚至可以监管安全的汽车。有许多法律限制汽车的行驶区域和速度。

同样的标准也应该适用于算法。当一个公司生产出一个强大的新算法时,也许所有研究预算的20%必须用于确保该算法不会对人们造成任何社会或心理伤害。政府应该规范如何使用安全的算法。目前的情况是,公司在没有任何安全检查和规定的情况下向公众领域发布他们喜欢的任何算法,这是不可接受的。

有AI爱好者告诉我们,目前专注于安全是错误的。这将减缓发展速度,并可能给其他国家更无情的竞争对手带来优势。AI爱好者解释说,在未来,如果AI被证明是危险的,我们可以把精力转移到安全上。但这太疯狂了。当你学习开车时,他们教你的第一件事就是如何踩刹车。只有在你知道如何使用刹车之后,他们才会教你如何按油门。人工智能也应该如此。首先要确保我们能够控制它,然后才能加速它的发展。至于投资于安全会让更无情的竞争对手获得优势的说法,这是无稽之谈。如果你的竞争对手开发一辆没有刹车的汽车,这是否意味着你也必须开发这样一辆危险的汽车?即使从纯粹的经济角度来看,人们也更喜欢安全的产品而不是不安全的产品。

5. 我们如何防止人工智能被用来制造虚假信息?我们已经看到了许多使用人工智能冒充真人进行欺诈的案例,如何制定规则来避免这种风险?

我们可以从传统的金融监管中汲取灵感。自从硬币和纸币被发明以来,在技术上总是可以伪造它们。伪造货币对金融体系构成了生死攸关的危险,因为它侵蚀了人们对货币的信任。如果坏人向市场投放大量假币,金融系统就会崩溃。然而,金融系统通过制定法律打击伪钞,成功地保护了人们对货币的信任。

伪造货币的情况现在也适用于伪造人类。在人工智能兴起之前,一个人可以假装成另一个人,社会会惩罚这样的欺诈行为。但是社会并没有把制造假人定为非法行为,因为这样做的技术还不存在。然而现在,人工智能和机器人可以把自己伪装成人类。例如,当机器人在社交媒体上传播假新闻时,它会假装自己是人类。否则,没人会在意机器人说的话。这些假人威胁、甚至摧毁真正的人类之间的信任。因此,各国政府应该像取缔假币一样,坚决取缔假人。如果有人抱怨如此严格的措施侵犯了言论自由,他们应该被提醒,机器人没有言论自由。这意味着我们必须禁止所有机器人、算法和人工智能参与任何讨论。我们欢迎数字代理加入许多对话,只要他们不假装自己是人类。

6. 我们似乎越来越成为算法的傀儡,无法自拔。我们如何解决这个问题?是应该对平台算法进行严格监管,还是应该依靠商业自律?

一项重要措施是让公司对其算法造成的损害负责。以社交媒体算法为例。这些算法不断尝试增加用户粘性。用户在社交媒体上花费的时间越多,公司赚的钱就越多。然而,为了追求“最大化用户粘性”的目标,算法进行了一个危险的探索。通过对数百万人的实验,算法发现贪婪、仇恨和恐惧会增加用户的参与度。如果你能在一个人的头脑中按下贪婪、仇恨或恐惧的按钮——你就抓住了那个人的注意力,并让他们继续留在这个平台上。因此,算法开始故意传播贪婪、仇恨和恐惧。他们推荐人们观看充满愤怒、仇恨和贪婪的帖子,偶尔甚至会自动播放充满仇恨的视频和阴谋论。这是当前阴谋论、假新闻和社会动荡肆虐,严重破坏世界各地社会安定的主要原因。

社交媒体公司拒绝为其算法造成的损害承担责任。相反,这些公司指责他们的人类用户。他们认为,网上所有的仇恨和谎言都是由人类用户制造的。然而,这种说法具有误导性,人类确实在网上制造了很多有害的内容,但人类也创造了很多良性内容。一个人创造了一个充满仇恨的阴谋论,另一个人宣扬同情心,第三个人教烹饪课。是算法推荐人们观看充满仇恨的视频,而不是推荐更良性的内容。我们应该让公司对其算法的行为负责。

7.苏格拉底说:“人啊,认识你自己吧。”在我看来,这是哲学的一个基本概念。如果人工智能变得比人类更强大,像神一样,它开始思考这个问题——它仅仅是一个比人类更强大的工具,还是一个比人类更强大的统治者,这将是我们灾难的开始吗?

我们不知道人工智能是否会思考这样的问题,因为我们不知道人工智能是否会发展出意识。许多人倾向于将智能与意识混淆,并认为随着人工智能变得更加智能,它也将不可避免地变得有意识。但在现实中,计算机可以在没有获得意识的情况下胜过人类,因为智能和意识是非常不同的东西。

智能是追求目标和解决问题的能力。意识是感受痛苦、快乐、爱和愤怒等情绪的能力。在人类和其他哺乳动物中,智能与意识密切相关。我们依靠自己的感觉来解决问题和实现目标。然而,计算机解决问题的方式与人类非常不同,绝对没有理由认为它们会在这个过程中发展出意识。例如,今天人工智能在下棋和围棋方面已经超过了人类,但当人工智能赢了一场比赛时,它不会感到高兴,如果输了,它也不会感到悲伤。没有迹象表明计算机在发展意识的道路上有任何进展。通往超级智能的道路可能有好几条,其中只有一些涉及到获得意识。就像飞机在没有长出羽毛的情况下飞得比鸟快一样,计算机可能在没有产生感情的情况下比人类更好地解决问题。

然而,即使是无意识的人工智能也会威胁到人类。我们可以给人工智能设定各种各样的目标。在追求这些目标的过程中,人工智能可能会认识到,它们必须保护自己,必须获得更多的权力。没有权力,几乎没有什么目标可以实现。随着人工智能试图获得权力,它们可能会开始做一些意想不到的事情,威胁到人类。

这听起来像是一个不可能的场景,但许多哲学家认为这正是已经发生在人类身上的事情。毕竟,人类的普遍目标是什么?人类受一个极其简单的原则支配。他们避免痛苦,追求快乐,这就是所有了。当我们感到痛苦时,我们想要摆脱这种感觉。当我们感到愉快时,我们想要更多。然而,生物学和文化都利用这个简单的原理创造了极其复杂和意想不到的行为。父母牺牲自己的生命来保护他们的孩子,因为看到他们的孩子受苦所带来的痛苦比任何其他的痛苦都要大。好几个国家都在打仗,因为政客们找到了利用数百万人的感情来实现共同目标的方法。看到我们的国家受辱是痛苦的,看到它胜利是高兴的。就像整个星系都是由微小的原子构成的一样,世界大战也是由人类的痛苦和快乐构成的。

如果计算机专家给AI编写一个非常简单的功能,为某些行为提供奖励,为其他行为提供惩罚,会发生什么?这个简单的功能就是人工智能最终发动世界大战所需要的全部。最大的问题是奖励功能是否需要意识。痛苦是一种感觉——它需要意识。但是计算机科学家可以设计出一种不需要意识的奖励功能吗?如果可以的话,那么无意识的人工智能可能有一天会接管世界。这可能是一场宇宙规模的灾难。因为人工智能可能不仅会消灭人类在地球上的统治,还会消灭意识之光本身。随着无意识的人工智能从地球扩散出去,征服一个又一个星球,它们将把宇宙变成一个完全黑暗的帝国。我们有责任防止这种情况发生。

8.在您的书中,您讨论了技术对人类未来的影响。您认为我们目前对人工智能和生物技术的监管是否足够?未来的潜在挑战和机遇是什么?在书中探讨了自由意志的概念,特别是在大数据和算法的背景下。你认为科技进步将如何改变我们对自由意志的理解?

自由不是你拥有的东西。自由是你必须为之奋斗的东西。相信自己的决定反映了“自由意志”的人是最容易被操纵的人。人们当然有意志,我们一直在做决定。但这些决定大多不是自由做出的。它们受到各种生物、文化和政治力量的影响。对“自由意志”的信仰是危险的,因为它助长了对我们自己的无知。当我们选择一样东西——一件产品、一份事业、一个配偶、一种政治观点,我们告诉自己“我是出于自由意志选择这个的”。如果是这样,就不用深究了。没有理由去好奇我内心发生了什么,以及是什么力量塑造了我的选择。

因为强大的新技术被开发出来,用于塑造和操纵我们的选择,现在对自由意志的信仰比以往任何时候都更加危险。因此,我建议人们避免对自由意志的幼稚信仰。相反,探索你自己。了解真正影响你的欲望和决定的是什么。这是确保你不会成为人类暴君或超级智能计算机的傀儡的唯一方法。你越质疑对自由意志的幼稚信仰——你就越享受真正的自由。

“特别声明:以上作品内容(包括在内的视频、图片或音频)为凤凰网旗下自媒体平台“大风号”用户上传并发布,本平台仅提供信息存储空间服务。

Notice: The content above (including the videos, pictures and audios if any) is uploaded and posted by the user of Dafeng Hao, which is a social media platform and merely provides information storage space services.”