蔡凯龙评论:人工智能发展目前最大的障碍在于缺乏人类的信任。人类不愿意相信机器,因为人工智能冰冷的理性思维无法理解人类感性思维,以及人类在伦理道德上的规范。我们难以相信机器人在面对伦理道德抉择的时候,能做出“人性”的判断。归根结底,我们人类和机器人不一样。而且人类天生具有优越感,毕竟聪明强大的AlphaGo也是人类创造出来的,所以无法把包括伦理道德在内的所有决定都交给机器人负责。这是对人类尊严的亵渎。然而人工智能势不可挡,人类该不该信任机器?解决办法很简单,技术提升,让机器人有情感,能够和人类一样感性判断,人类就可以信任它。这个方法乍看可行,但是目前技术上很难实现。即使技术上有可能,人类会因为恐惧而不敢使用。我们愿意面对一个强大的、理性的、行为可预测的机器人,还是一个强大的、感性的、行为不可预测甚至有主见的机器人?另一个解决办法,人类自身改变。人类不信任机器人根源在于人类的心理。人的适应能力很强,随着时间的推移、人工智能的发展和普及,人类逐步调整自己的心态,逐渐信任机器人,与之共存。看看手机出现到现在短短20多年,人类对手机依赖的转变历史,我们不难推测,在不远的将来,人类和机器人关系也会如此。信任问题解决了,但是原来的问题依旧存在:人类愿意抛弃尊严和优越感,把包括伦理道德的所有决定交给机器人吗?把充满未知性和不确定性的人类社会变成一个纯粹理性和计算出来的社会?这是一个大问题!

以下内容为编译正文:

人工智能给人类带来新的革命。随着这些机器更广泛地融入到我们的日常生活,这些机器所做的决策将超出纯粹的事务范围,必将延伸到道德伦理层面。 比如,当无人驾驶汽车遇到不可避免的交通意外的时候, 它选择保护车上乘客还是尽量最小化事故损失。又譬如,无人飞机在有平民伤亡的前提条件下,是否继续打击企图发动袭击的恐怖分子? 随着具有人工智能的机器变得越来越自动化,这些是不可避免的问题。

把道德伦理抉择交给计算机是有好处的:不像人类, 机器不会被认知偏见所迷惑、不会疲劳、不会对敌人产生憎恨。 理论上, 人工智能能被设定成符合理想中的道德楷模的价值观和做事原则。 没有人类的局限性,这样的机器人甚至能比人类更加擅长做出更好的伦理道德择决。 然而,机器将主宰伦理道德抉择这种想法让很多人很担心,因为机器在这个领域的使用从根源上威胁到人类的尊严。为什么我们不愿意信任机器人做出的伦理道德抉择? 心理学研究提供了一个答案:人们不信任那些通过计算成本和收益做出伦理道德抉择的人,比如计算机。

这个研究成果和长期积累下来的传统信条有冲突。 传统信条认为,伦理道德决定需要评估和计算后果。拥护这种想法的学派(或者称为结果导向主义者)声称:一个决定若能带来更好的结果,这个决定才能被称为伦理道德上正确的决定。 然而,大多数不相信传统信条的人认为这样的决策不适合人类伦理道德观。事实上,人类的伦理道德观倾向于符合一套道德规范,这些规范里的某些行为是“不对”的,却能产生好的结果。

在一系列的心理学实验案例中,参加者被置于假设中的道德困境里左右为难,参与者需要选择成为结果导向主义者还是遵循一套道德规范。实验结果显示,参加者大多选择遵循道德规范而不是结果导向。比如在“足桥困境”里,参与者被告知一辆行驶过来的火车即将撞上5个困在铁轨上的无辜者,前面刚好有个巨人站在火车即将穿过的足桥上,只要把这个巨人推下足桥,虽然巨人会被火车撞死,但是因为其身体庞大,能挡住火车避免继续碾压后面5个无辜者。大多数人觉得不应该把巨人推下桥,虽然牺牲巨人救回5个人是最好的结果。

问题是,我们如何看待一些少数人,他们愿意冷血地牺牲生命去追求更好的结果? 去年实验心理学杂志发表一篇论文提出:科学家找到很多证据证明,在正常情况下,结果导向主义者不受大家喜欢;换句话说,在社交关系上,结果导向特征反而是一个负面因素。

我们推断基于道德规范的人,虽然行为的结果不一定最好,但这类人适合成为社交伙伴。这听起来很有道理:如果你的朋友或者伙伴精于算计,无时不刻在计较得失,甚至可能为了更好的结果,决定欺骗你、对你说谎甚至谋害你,这样的朋友大多数人很难接受。道遵循德规范被看成是有责任感的一种显著的标志(也许是因为遵守道德规范体现了我们带有某些特定的情感去与人相处)。

我们在2400多人参与的9次实验中精准地发现:选择遵循道德规范的人比选择结果导向的人更加值得信赖。坚持道德规范的人在金融领域优势更加明显。 在一个测试信任度的金融实验中, 我们发现:对坚守道德规范、拒绝牺牲生命去追求更好结果的金融从业者,实验的参与者愿意拿出更多的钱交给他们管理,也更加坚信能拿回投资。

但是结果为导主义者并不是被一概否定。面对是否为了救多人而去牺牲一个人的困境选择时, 选择“很难决定”的人和选择“绝不接受”的人同样值得信赖。 在这种情况下,决策者的矛盾和犹豫能体现一个人的正面特征。 因为,这意味着这个人不管最后如何选择,都感受到道德规范的约束。

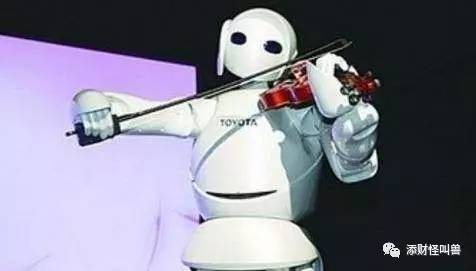

这些研究发现和机器人有什么关系? 这些研究指出人类在伦理道德领域对机器人不信任的一个可能原因:人工智能缺乏我们用来获取信任的特性。 我们人类倾向于非理性地、不计后果地遵守某些原则。我们比较接受这样一类人,他们的道德行为是由人类社会共有的情绪所决定,比如内疚和同情。遵守原则体现了人类内心深处的心理特性。即使假设机器能完美地模仿人类的伦理道德抉择, 我们也深知计算机做出判断的依据和我们完全不一样。不管机器人做什么决定,人类在伦理道德领域上无法信任他们通过计算而做决策的方式。事实上, 一份人权观察组织报告最近提出暂停研究杀人机器人,因为这样的机器人不会像人类一样有着不杀害或者伤害同胞的本能。

换句话说, 让机器做出正确甚至绝佳的决定,这远远不够。 我们希望机器通过和人类一样的心理过程后做出抉择:也就是说,希望机器有情感的反应和直觉的反应。人类演化多年形成这两种反应让人类成为特有的道德生物。 如果技术在达到让机器人有情感和直觉这一成就之前,任何试图让机器人自动做出道德伦理决策的尝试都会受到怀疑。 或者我们最后发现,其问题的根源不在机器人,而是在我们的心理。

中泽嘉盟投资基金合伙人,财经专栏作家,互联网金融千人会联合创始人, 台湾金融研训院讲课老师。 曾任联想控股旗下P2P翼龙贷副总裁,德意志银行(美国)战略科技部副总裁, 担任美国休斯顿大学商学院金融系助理教授。注册金融分析师(CFA), 金融风险管理师(FRM), 经济和计算机双硕士,金融系博士生。FTchinese, 新浪财经,腾讯财经,财新和凤凰财经等知名财经媒体的专栏作者。编辑出版《智慧众筹:互联网金融早餐会》一书(腾讯CEO马化腾,前央行副行长吴晓灵序) 中国金融出版社 2015 ; 《 区块链技术驱动金融:数字货币和智能合约技术》中文版译者,中信出版社 2016; 《区块链:金融科技与创新》中文译者 (前台湾行政院长陈冲序),台湾金融研训院 2017。